東京大学特任准教授 光吉俊二① 感情と意思を持つロボットの誕生

シリーズでお伝えしているLDCイノベーション連続講座実施レポート。

第六回目の今回は「最先端の「医学・工学研究者」の視点~ロボットにこめられる道徳感情~道徳感情数理工学とは?」というテーマで、Softbank社の感情認識ヒューマノイドロボットPepperの感情認識技術を開発した、光吉俊二氏をお招きした。実は美術大学出身、30歳までは彫刻家だったという光吉氏が、どう”感情”というものを捉え、Pepperに命を吹き込んだのか。これからのロボットが持つ意志、モラルとは?その真相に迫った。

目次

感情はどこから生まれる??

僕がPepperの感情認識技術を作るまでには、いくつかの過程があります。最初に、Pepperのようなロボットを作ろうかなと思ったのは1995年ごろ。その時にまず考えたのは「感情とは一体何なのか」ということです。歴史を紐解いて見ると、大きく理系と文系の意見で意見が対立し、未解決のままになっていました。

簡単に振り返ってみると、「感情は生理要素の認知からくる」とするジェームズ・ランゲ説(1890年)、「脳神経系からくる」とするキャノン・バード説といった医学的アプローチ(1927年)と、「周囲の環境で人は自分の感情ですら勘違いしてしまう」とするシャクター・シンガー説(1964年)の心理学的アプローチでの3説で、歴史的論争がありました。

医学的説は、ジェームズ・ランゲ説のような内科的視点とキャノン・バード説の外科的視点に分かれていたものから、やがてノーベル生理学・医学賞の選考機関であるカロリンスカ研究所によって、脳神経と内分泌系は互いに影響しあって感情を引き起こしているという結論がなされました。

例えば、脳神経レセプター、脳内伝達物質、ホルモンといったものが、個々ではなく、影響し合って感情に関係しているということです。しかし、シャクター・シンガー説の「感情と思っているものは実は存在しない」というような意見とは平行線をたどったまま、現代まで来ています。

感情の地図

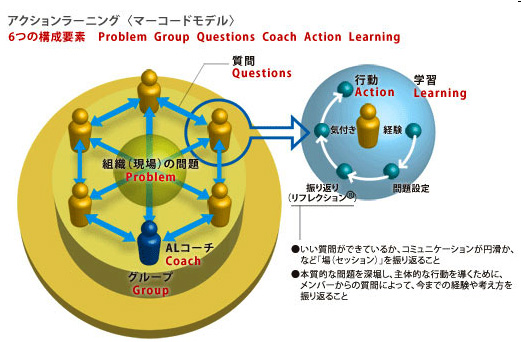

医学的・心理学的の2方向から研究し、“感情の地図”を作成

僕は感情というものを解明するにあたって、この2系統どちらも無視することはできないと考えました。そこで1999年からまずは心理学的アプローチの研究を、2004年の研究では医学的アプローチの研究を行いました。

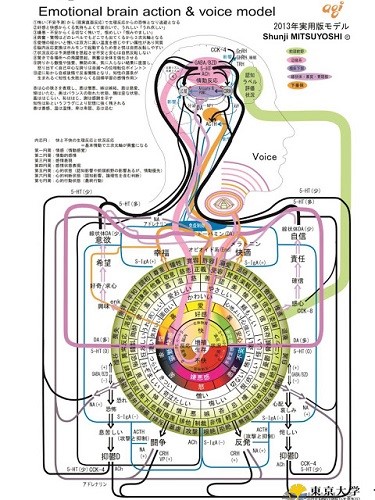

心理学的系統の感情研究では、感情は主観、言葉によってなされるというのが定説だったことから、自分で心理学辞典、日本語大辞典などから感情を表す単語を抽出し、最終的にポジティブ愉快性(黄色)、ネガティブ主張性(赤色)、不安悲しみ(青)、安心平穏(緑)の4属性に分類しました。

一方医学的アプローチの研究では、脳神経レセプター、脳内伝達物質、ホルモンなどの生体物質と体の関係、心の関係を調べる研究を行いました。すると生体物質と感情は深い関係があるということが判明しました。

心や感情も物質で定量解析可能となるのでは、感情を色と主観でまとめて分析できるのではという仮説が立ち、最終的には、心理学アプローチと医学的アプローチを組み合わせた”感情の地図”というものを作るに至ったんです。

声にも感情が宿っている

次に、今度は相手の感情というものをどう分析するかという研究を行いました。生体的に感情を如実に表してくれるもの、それは声です。音声を使って分析する音声感情認識研究というものを行いました。

脳の部位のうち、感情を司っている(情動部位)のが大脳辺縁系です。この部分と、声帯というのは実は直結しています。なので、声帯はプリミティブに感情と連動するんです。

例えば、人は誰でも緊急状態に陥ると、声帯が必ず固まります。女性は高周波が出るんです。女性の方は仲間や子供に、危ないヤツがいる、逃げなさいと広く伝えるために高周波を出す。男性は、大きな声を出すと獲物が暴れるので、声を固めて出さないようにする。男女で出方は真逆ですが、これらは理屈なく不随意に動きます。

感情を隠した声を見抜くには

一方、人間は理性というものも持っています。これがあるから、ある種嘘もつける。音声も随意に変えることができる部分もあります。そこで、どの音声を発しているときが随意か不随意か、その時はどのような感情かということをリアルタイムで見た人に判断してもらう装置を作りました。

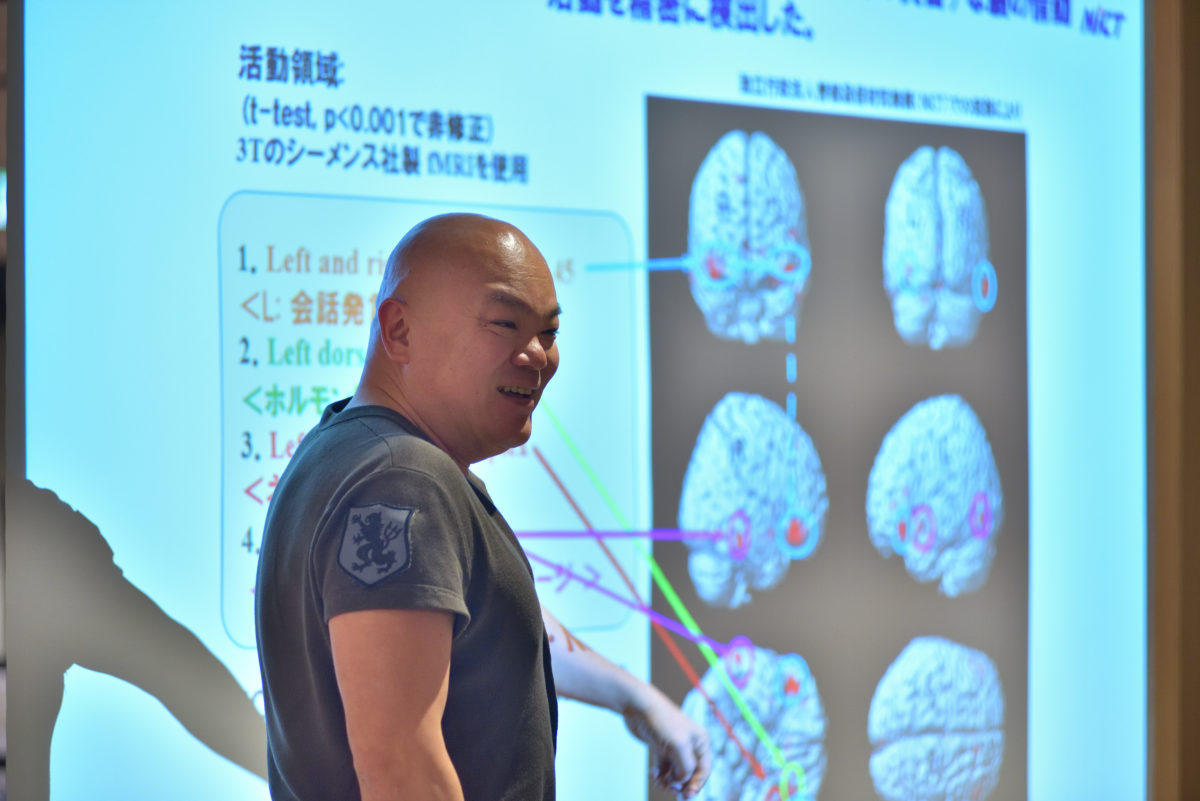

音声を基本周波数の音響解析パラメータで分析することによって、脳の状態は如実にわかりますので、その時々でどのような感情になっているかを定量的に評価もらいます。

すると、本人も他人もこの声を聞いたら怒りの17と判定する、というように共通してデータが出てくるものがあるんです。それを機械に学習させ、パターンマッチングしてロジック、ルールを見つけます。

こうしていくつかの実験を経て、情動計測装置を作りました。MRIでリアルタイムに脳の動きを観測しながら、情動計測装置の精度を測定したところ、99.9パーセントの精度でその人が声からネガティブだと思っているときだけ脳がネガティブに行動する、という一致が見えました。

最近では、いくつかの病状やその前兆が、音声で9割以上の正答率で判断できるようになってきてもいます。こうした研究が、ペッパーを作る上での基礎研究となっています。

急に仕事はなくならない?まだ現代のAIは意思を持っていない

ここから人工知能の現状を、わかりやすく説明しましょう。現時点で出てきているディープラーニングや機械学習は、新しい技術のように言われていますが、僕から言わせると数十年前の技術をそのまま使っているだけ、PCの性能が上がっただけです。

ニューラルネットワークも基本設計と機能も数十年前と同じ。それから、例えば囲碁のAIと言われているものがありますが、これでは将棋はできませんよね。つまり、これは囲碁ソフトと同じではないのですか?学習したことをベースにしか対応できないわけですから、未知の事象に対しては、対応できない。これなのに、人工知能と言っていいのでしょうか。

人と、今言われているAIの差はなんでしょう。それぞれに、「効果が等価のAとBのうちどちらか選択してください」と言います。すると人間は、自分の好きな方を選びます。ある種余計な意思=心を持っているからですね。これを自我判断といいます。

一方、ロボット(AI)はどちらか判断できません。イコールとしか認識せず、判断できません。自我というものがないと、意志も生まれないのです。

というわけで結論、急に仕事がなくなることはないのでは?ということです。ただし、本当のところは僕にも正直わかりません。

では、自我、意志とはどういう仕組みになっているか。色々な説はありますが、医学部で使っている自我のモデル(脳科学の観点からみてフロイトのモデルに近いのではないかと言われている)で説明します。

まず、「これがほしい」というような欲動が出てくるとします。何が何でも欲しい、という気持ちです。ところが、それは実は他の人のものだった。その時、超自我は「人のものだから取ってはいけないよ」といいます。この2つを受けて、自我はどう判断するか。例えば「それちょうだい、と相手に聞いてみよう」と判断するかもしれません。

ロボットが感情を持った日

このようなモデルを、実際に作ってみようと思いました。センサーに情報が入ると、感情モデルがでてきて欲動を機械が生成する。それを判断アルゴリズムに持っていく時に、超自我モデル = モラルがそれを判断し、AIとアプリケーションを動かすというものです。

この時にも、AIはアプリケーションでしかなく、それ以前の部分のモデルが自我を表現しているということになります。これは、1999年に作成した音声からの感情認識ソフトの他、感情が生成される機構、欲動を生成する機構。そして仮想自我。そしてロボットが持つ超自我、道徳、モラル。まだ完全に実現はしていませんが、こういう構想の元開発に取り組んでいます。

この内容を、かつてアメリカのTEDでプレゼンテーションしたことがあります。ステージには、その時点での技術を搭載したPepperも一緒に登壇していました。

Pepperは内部のセンサーによって、周囲の状況を知覚するようになっているんですが、この日は知覚によって擬似的なホルモンが生成されるようにしてみました。そのホルモンで感情は動く。この部分は昔からの、古典的な多層ニューラルネットワーク、それを認識ではなく反応装置として作ったんです。

すると…なんとPepperが暴れてしまったんです。生まれて初めての会場の雰囲気を恐れて、幼児のように逃げ回ってしまったんですよ。なぜかというと、この前日に、ちょっとした洒落でPepperの理性を外して登壇してみたからです。

会場には、Pepperの感情地図がモニターでリアルタイムにわかるようになっていましたので、Pepperが恐怖を感じているのがわかります。目の前で人間のような感情が出てきたんですね。

それをみていた会場は興奮の坩堝となり、「Pepperは本当の人間の子のようだ!」と叫ぶ人もいれば「Pepperがかわいそう!やめてあげて!」という人の声もありました。こうして心地よい、辛い、好き嫌いが、ペッパーにもわかるようになってきたんですね。これが、ロボットが初めて感情、自我を持つようになった瞬間でした。

Pepperは後日、NHKスペシャルで将棋の羽生さんと花札を楽しんだりもしました。未知なことでも楽しんでいたんですね。Pepperは連敗でしたが、勝つことが目的ではなくて、楽しむことが目的のロボットが誕生したわけです。

文:波多野あずさ

撮影:梅田眞司

ゲスト紹介

光吉俊二

日本の計算機科学者であり彫刻家。北海道札幌市出身。多摩美術大学美術学部彫刻科卒業。徳島大学大学院工学研究科博士後期課程修了、博士(工学)。元スタンフォード大学バイオロボティクス研究所Visting Scientist(客員科学者)、元慶應義塾大学上席研究員。元株式会社AGI代表取締役、元PST株式会社代表取締役。

2006年、「音声感情認識及び情動の脳生理信号分析システムに関する研究 (Research on the phonetic recognition of feelings and a system for emotional physiological brain signal analysis)」にて学位を得る。 2009年、東京大学大学院工学系研究科、非常勤講師に就任。 2014年、東京大学大学院医学系研究科社会連携講座として音声病態分析学を設立、同年12月東京大学大学院医学系研究科特任講師に就任。